Con el fin de ayudar a las personas con discapacidad visual a navegar por las calles, el estudiante universitario Satinder Singh ha presentado una solución innovadora que literalmente empuja al usuario en la dirección correcta.

El sistema de Singh, llamado DeepWay, usa una cámara montada en el cofre para tomar imágenes de la carretera que el usuario está caminando hacia abajo, luego alimenta esta información a una computadora portátil para su procesamiento.

Tal vez pueda interesarte proyectos en arduino, pic, robótica, telecomunicaciones, suscribete en http://www.youtube.com/user/carlosvolt?sub_confirmation=1 mucho videos con código fuentes completos y diagramas

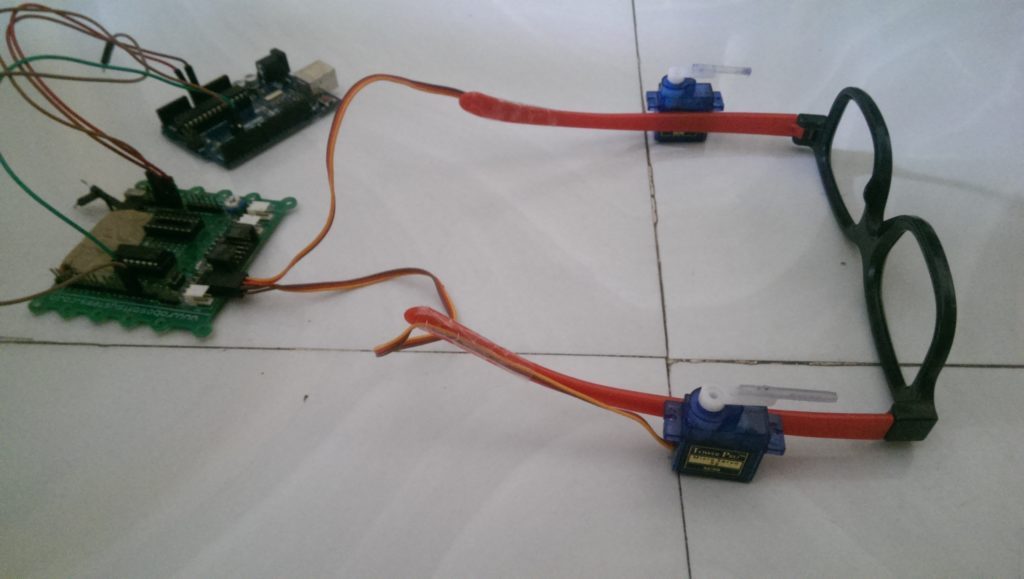

Si el algoritmo de aprendizaje profundo determina que el usuario necesita moverse hacia la izquierda o hacia la derecha para mantenerse en el camino, se envía una señal en serie a un Arduino Uno , que a su vez controla uno de los dos servos montados en un par de anteojos para tocar a la persona Indique en qué dirección caminar. La retroalimentación ambiental adicional se proporciona a través de un par de auriculares.

Este proyecto es una ayuda para los ciegos. Hasta la fecha no ha habido avances tecnológicos en la forma en que los ciegos navegan. Así que he usado el aprendizaje profundo, particularmente las redes neuronales convolucionales para que puedan navegar por las calles.

Mi proyecto es una implementación de CNN, y todos sabemos que requieren una gran cantidad de datos de capacitación. Así que la primera obstrucción en mi camino fue un conjunto de datos correlacionado de imágenes. Así que fui a mi universidad y grabé muchos videos (de todo tipo de caminos y también fuera de carreteras). Luego escribí un script básico de Python para guardar imágenes del video (guardé 1 imagen de cada 5 fotogramas, porque el fotograma consecutivo es casi idéntico). Recolecté casi 10,000 de esas imágenes, casi 3,300 para cada clase (es decir, a la izquierda y al centro).

Hice una colección de arquitecturas CNN y entrené el modelo. Luego evalué el rendimiento de todos los modelos y elegí el que tenía la mejor precisión. Obtuve una precisión de entrenamiento de aproximadamente 97%. Obtuve aproximadamente la misma precisión para todo el modelo entrenado, pero me di cuenta de que el modelo en el que se aplicaba la regularización tenía un mejor rendimiento en el conjunto de prueba.

El siguiente problema fue cómo puedo decirle a las personas ciegas en qué dirección moverse. Así que conecté mi programa Python a un Arduino. Conecté los servomotores a Arduino y fijé los servomotores a los lados de un espectáculo. Utilizando la comunicación serial, puedo decirle al Arduino qué servomotor mover, que luego presionaría hacia un lado de la cabeza de la persona ciega y le indicaría en qué dirección moverlo.

Se puede ver una demostración de DeepWay en el siguiente video, mientras que el código para este proyecto de código abierto está disponible en GitHub .

Tal vez pueda interesarte proyectos en arduino, pic, robótica, telecomunicaciones, suscribete en http://www.youtube.com/user/carlosvolt?sub_confirmation=1 mucho videos con código fuentes completos y diagramas

SUSCRIBETE A NUESTROS BOLETINES, RECIBE EN TU CORREO LAS NOTICIAS MÁS DESTACADAS, SÓLO INGRESANDO TU CORREO ELECTRÓNICO

[wysija_form id=”1″]

VIDEO RECOMENDADO